免费sitemap 工具生成10万页面XML格式网站地图

免费sitemap 工具生成10万页面XML格式网站地图

前言

只要只从事过网站管理员或者SEO工作的人一定不会对XML格式的sitemap陌生,为了提升搜索引擎抓取网站的效率,需要把使用工具把网站里面所有的页面的URL按照W3C的标准制作成索引文件,再通过搜索引擎的站长工具提交。搜索引擎蜘蛛就可以按照这个索引文件按图索骥,大大方面的提升抓取效率

所以这个xml版本的sitemap文件是刚需,但是能制作这个文件的方法确不多。一般是两类工具来制作。

网页工具:因为这个文件需要占用很多网络资源 长时间的爬取网页,国内基本没有这样的雷锋,可以帮助你来做。就算国外的工具,也只适用于爬去1000个页面以内的页面 ,如果页面再多就无能为力。必经网络资源是有成本的

另外一类是桌面工具:这类工具国产有许多,但是基本都是收费的,毕竟别人开发工具有成本 而且这个工具没有太大的粘度,基本上也无法带来流量变现,想找到一款合适的实在很难,机缘巧合我找到了一款。就是本文的主角老虎地图。它是一款良心工具,免费,绿色免安装,功能强大,多线程,高度个性化定置。能安装规则爬取。

但是如果只是介绍一款工具运用 网站有许多这样的文字,本文主要是介绍在使用这款工具爬取超过10万多页面的网站的技巧。如果只是爬取几千页面的文字,可以忽略、

项目背景

目前有一个国际客户,中文内容,目前我们的需求是制作一份中文的站点地图文件。

项目挑战:

网站是一个全站站点,里面链接错综复杂,并且中英内容交叉,还有大量深不可测的网址(链接参数无线死循环),使用工具爬取了1天1夜,只能爬取10w个页面但是工具显示这个网站还有90万多的页面没有爬取,并且这个未爬取的数量还在增加,照这样下去,10天10夜也无法完成任务

项目分析思路:

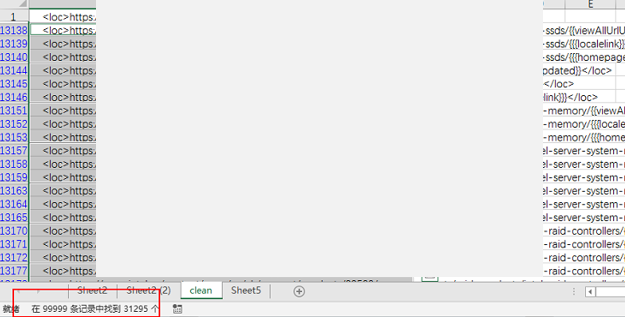

于是我们就导出了已经爬取的10w个页面,进行分析,查看是什么类型的链接,是否都是必要的,如果不必要,如何避免被加入到sitemap,找出其中大部分不需要的网址的规律,添加到爬取或者过滤器中,提示爬取效率

实施技巧:

数据分析工具的选择:

这里要声明下 excel不是处理这种超过十万行数据比较好的方法,可以使用sublime或者tableau等,这里使用excel主要是为了效率,因为其他工具不熟,然后工具速度慢,但是人的操作熟练度比工具的效率对结果的影响更大,所以适合自己的工具才是最好的

过滤的策略:

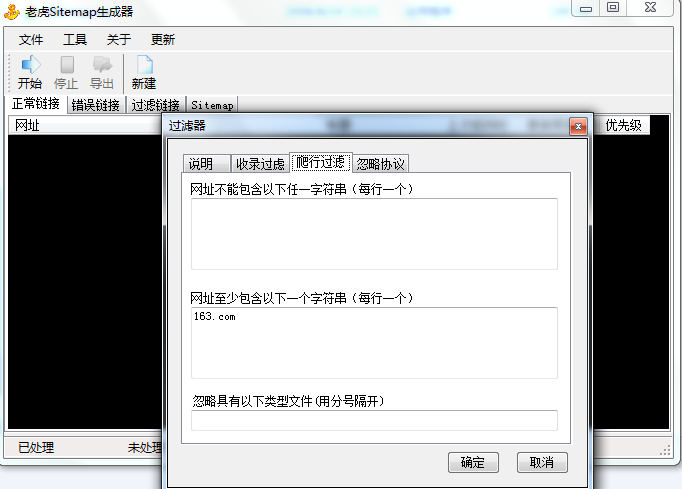

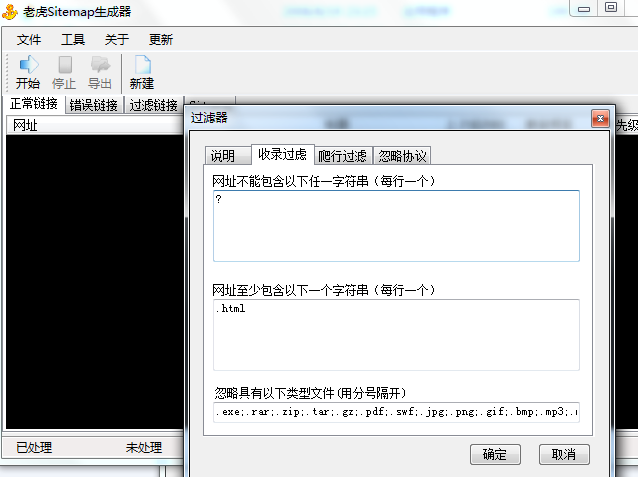

这个工具有2个过滤策略,一个是爬取过滤,就是爬虫都不会去爬,还有一个是收录过滤

爬取过滤

就是决定是否添加到sitemap中,在爬取过滤中已经添加了一些脚本 邮件协议等不能抓取的,其他默认都是可以抓取的,但是这个客户的网站有需要是其他国家的,我们可以通过增加URL中其他国家的代码 把别的国家排除在外,或者使用包含命令 只包含自己国家代码的URL 过滤规律 把其他国家的网址都排除在外

收录过滤

在收录过滤中我们的可以把带有.html 作为包含在内 ,这个客户的URL有很多套,带有参数的带有?的我们都不需要他们真正需要优化的是html都已经做了静态化.所以我们做的url 需要包含.html,但是也有一些特例如.html/abc/dfdd?ddd 这样的,所以我们就添加了一个排除命令.hmtl/ 这样的既不是以.html结尾的我们都排除了

基本上使用好过滤就可以把我们抓取的页面从10w迅速减少到2w,大大提升抓取效率,如图我们使用了其中一个过滤方法后 从10w页面降低到6w

在增加一个排除字符串? 即把所有带有参数的网址都排除(但是还是可以继续抓取,通过抓取可以这个页面上是否还有其他复合要求的网址)

进一步优化空间:

这个工具的过滤规则 不支持正则匹配,稍微复杂的规则就不能胜任,建议增加正则匹配选项

目前的包含字符串规则 无法写并列包含,也就是如果我需要抓取的网址

包含abc 还要同时包含123 就无法满足

最后附上工具链接

链接: https://pan.baidu.com/s/1vfro0iNqYf9-qYwjVN7F8g 提取码: 2eu2

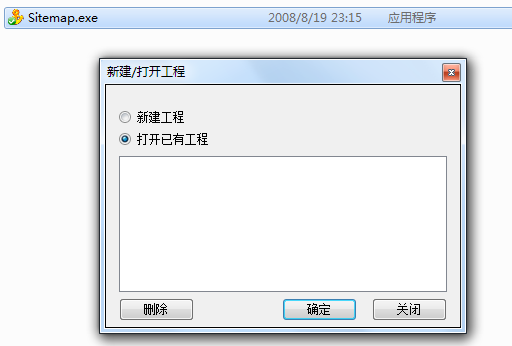

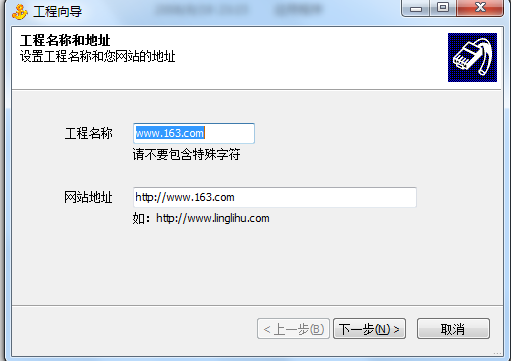

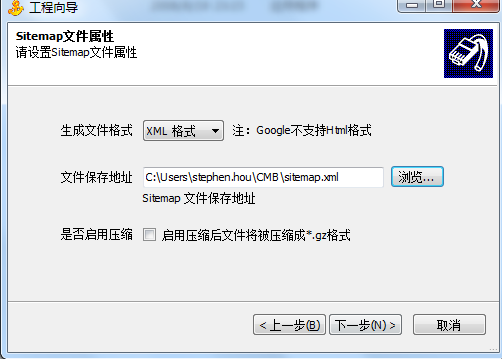

工具简单介绍